Study

[용어 정의] CPU, GPU, TPU의 정의

CPU와 GPU는 분석을 하지 않는 사람들도 많이들 알고 있는 이름이고, 컴퓨터 사양을 볼 때도 많이 보는 이름인데, TPU는 영 낯설다. 그런데 논문에서 사용한 스펙을 보다보면 TPU라는 이름이 자주 등장한다. 그리고 Colab을 쓸 때도 TPU를 선택하는 버튼이 있다. 모르고 안쓰는 것보다 알고 써보자라는 생각으로 적어놓는 CPU, GPU, TPU에 대한 정의. CPU(Central Preocessing Unit) CPU는 중앙 처리 장치라는 의미로, 컴퓨터 시스템을 통제하고, 프로그램의 연산을 실행하고 처리하는 핵심적인 컴퓨터의 제어장치를 말한다. 다시 말하면 컴퓨터의 가장 기본되는 연산 장치에 대한 칩을 의미한다. 컴퓨터를 구매할 때 가장 먼저 살펴보는 CPU로 컴퓨터의 전반적인 성능을 좌우하는 ..

[NLP/자연어처리] pre-trained model(3) - BERT(Bidirectional Encoder Representations from transformer)

2021.05.31 - [Study/NLP] - [NLP/자연어처리] pre-trained model(1) - ELMo(Embeddings from Language Models) [NLP/자연어처리] ELMo(Embeddings from Language Models) 2021.05.26 - [Study/NLP] - [NLP/자연어처리] Seq2Seq(3) - 트랜스포머(Transformer)_Encoder [NLP/자연어처리] Seq2Seq(3) - 트랜스포머(Transformer)_Encoder 2021.05.24 - [Study/NLP] - [NLP/자연어처리] Seq.. everywhere-data.tistory.com 2021.06.01 - [Study/NLP] - [NLP/자연어처리] pre-t..

[NLP/자연어처리] pre-trained model(2) - GPT-1(Generative Pre-Training of aLanguage Model)/OpenAI

2021.05.31 - [Study/NLP] - [NLP/자연어처리] ELMo(Embeddings from Language Models) [NLP/자연어처리] ELMo(Embeddings from Language Models) 2021.05.26 - [Study/NLP] - [NLP/자연어처리] Seq2Seq(3) - 트랜스포머(Transformer)_Encoder [NLP/자연어처리] Seq2Seq(3) - 트랜스포머(Transformer)_Encoder 2021.05.24 - [Study/NLP] - [NLP/자연어처리] Seq.. everywhere-data.tistory.com ELMo에 이어서 Pretrained 모델 중 하나인 GPT-1 에 대해서 이야기해보려 한다. 이는 OpenAI라고 하기..

[NLP/자연어처리] pre-trained model(1) - ELMo(Embeddings from Language Models)

2021.05.26 - [Study/NLP] - [NLP/자연어처리] Seq2Seq(3) - 트랜스포머(Transformer)_Encoder [NLP/자연어처리] Seq2Seq(3) - 트랜스포머(Transformer)_Encoder 2021.05.24 - [Study/NLP] - [NLP/자연어처리] Seq2Seq(1) - RNN을 이용한 시퀀스 투 시퀀스 [NLP/자연어처리] Seq2Seq(1) - RNN을 이용한 시퀀스 투 시퀀스 이전 RNN, LSTM, GRU에 대한 글을 보려면 아래 참조 20.. everywhere-data.tistory.com 2021.05.26 - [Study/NLP] - [NLP/자연어처리] Seq2Seq4 - 트랜스포머(Transformer)_Decoder [NLP/자연..

[NLP/자연어처리] Seq2Seq4 - 트랜스포머(Transformer)_Decoder

트랜스포머 인코더 부분은 아래 참고 2021.05.26 - [Study/NLP] - [NLP/자연어처리] Seq2Seq(3) - 트랜스포머(Transformer)_Encoder [NLP/자연어처리] Seq2Seq(3) - 트랜스포머(Transformer)_Encoder 2021.05.24 - [Study/NLP] - [NLP/자연어처리] Seq2Seq(1) - RNN을 이용한 시퀀스 투 시퀀스 [NLP/자연어처리] Seq2Seq(1) - RNN을 이용한 시퀀스 투 시퀀스 이전 RNN, LSTM, GRU에 대한 글을 보려면 아래 참조 20.. everywhere-data.tistory.com 해당 글은 딥러닝을 이용한 자연어 처리 입문의 내용과 Jay Alammar의 시각화 자료를 함께 정리한 내용입니다...

[NLP/자연어처리] Seq2Seq(3) - 트랜스포머(Transformer)_Encoder

2021.05.24 - [Study/NLP] - [NLP/자연어처리] Seq2Seq(1) - RNN을 이용한 시퀀스 투 시퀀스 [NLP/자연어처리] Seq2Seq(1) - RNN을 이용한 시퀀스 투 시퀀스 이전 RNN, LSTM, GRU에 대한 글을 보려면 아래 참조 2021.05.20 - [Study/NLP] - [NLP/자연어처리] 순환신경망 (Recurrent Neural Network, RNN) [NLP/자연어처리] 순환신경망 (Recurrent Neural Network, RNN) 해.. everywhere-data.tistory.com 2021.05.24 - [Study/NLP] - [NLP/자연어처리] Seq2Seq(2) - 어텐션 매커니즘(Attention Mechanism) [NLP/자연..

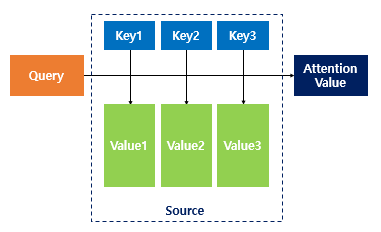

[NLP/자연어처리] Seq2Seq(2) - 어텐션 매커니즘(Attention Mechanism)

2021.05.24 - [Study/NLP] - [NLP/자연어처리] Seq2Seq(1) - RNN을 이용한 시퀀스 투 시퀀스 [NLP/자연어처리] Seq2Seq(1) - RNN을 이용한 시퀀스 투 시퀀스 이전 RNN, LSTM, GRU에 대한 글을 보려면 아래 참조 2021.05.20 - [Study/NLP] - [NLP/자연어처리] 순환신경망 (Recurrent Neural Network, RNN) [NLP/자연어처리] 순환신경망 (Recurrent Neural Network, RNN) 해.. everywhere-data.tistory.com 해당 글은 딥러닝을 이용한 자연어 처리 입문 의 내용을 바탕으로 정리한 내용이며, 시각적인 자료로 Jay Alammar의 블로그를 첨부했습니다. 0. 기본 Se..

[NLP/자연어처리] Seq2Seq(1) - RNN을 이용한 시퀀스 투 시퀀스

이전 RNN, LSTM, GRU에 대한 글을 보려면 아래 참조 2021.05.20 - [Study/NLP] - [NLP/자연어처리] 순환신경망 (Recurrent Neural Network, RNN) [NLP/자연어처리] 순환신경망 (Recurrent Neural Network, RNN) 해당 포스팅은 김기현의 자연어처리 딥러닝 캠프의 내용과 파이토치로 시작하는 딥러닝 입문 의 내용을 정리한 것입니다. 우리는 시공간의 차원에 살고 있다. 그렇기 때문에 시공간에 정의된 everywhere-data.tistory.com 2021.05.21 - [Study/NLP] - [NLP/자연어처리] LSTM(Long Short-Term Memory), GRU(Gated Recurrent Unit) [NLP/자연어처리]..